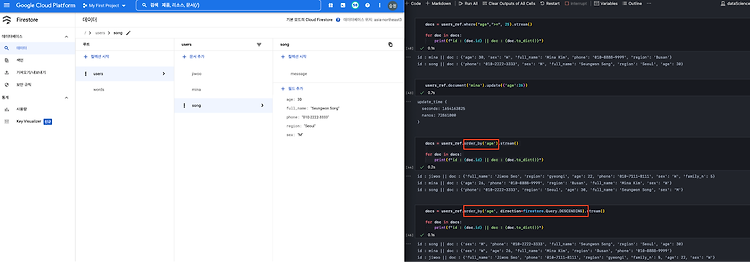

firestore를 사용하기 위해 먼저 구글 클라우드 플랫폼의 IAM 관리자에서 서비스 계정을 하나 만들어준다(이미 있으면 pass) 서비스계정을 만들면 자동으로 인증키 json 파일이 다운로드 된다. 해당 파일을 가지고 나의 firebase_admin을 초기화해주면 설정 완료. 설정(키 인식)이 끝났다면, 데이터를 넣어본다. 만약 doc_ref 변수로 지정한 collection과 document가 없다면 알아서 생성된다. *데이터 구조: 컬렉션 > 문서 > 필드 > 데이터 기존에 가지고 있던 collection, document가 있다면, 해당 경로에 데이터가 추가된다 문서 아래에는 하위 컬랙션을 추가할 수도 있다. 해당 컬랙션에는 message 정보를 담아보자 만약, 데이터프레임 형태의 데이터를 가지..